Правилният Robots txt за html сайта създава планове за действие за роботи на търсачките, като им казва, че те могат да проверят. Често този файл се нарича Протокол за премахване на роботи. Първото нещо, което търси ботове преди обхождане на уебсайт, е robots.txt. Той може да посочи Sitemap или да го уведоми, че не е проверил някои поддомейни. Robots.txt не се изисква, когато търсачките търсят най-често използваните. В този процес е много важно файлът да бъде правилно форматиран и да не индексира собствената си страница с личните данни на потребителя.

Принцип на робота за сканиране

Когато търсачката отговаря на файла и вижда забранения URL адрес, той няма да го сканира, но може да го индексира. Това се дължи на факта, че дори и роботите да нямат право да виждат съдържание, те могат да си спомнят обратните връзки, които сочат към отказания URL адрес. Поради блокирания достъп до връзката, URL адресът ще се появи в търсачките, но без фрагменти. Ако входящата маркетингова стратегия изисква коректни роботи txt за bitrix, осигурете проверка на сайта по искане на потребителя от скенери.

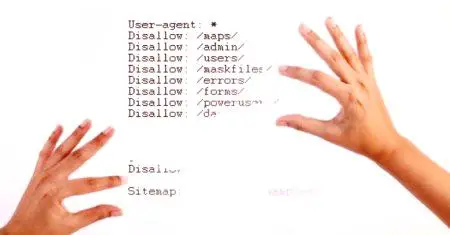

От друга страна, ако файлът е форматиран неправилно, той може да доведе до това, че сайтът не се показва в резултатите от търсенето и няма да бъде намерен. Този файл на търсачката не може да бъде прескочен. Програмистът може да прегледа robots.txt на всеки сайт, като отиде в неговия домейн и го следва, използвайки например robots.txtwww.domain.com/robots.txt. Използвайки такъв инструмент като секцията SEO Unamo, в която можете да въведете всеки домейн, и услугата ще покаже информация за наличието на файла. Ограничения за сканиране:

Потребителят има остаряло или поверително съдържание. Изображенията в сайта няма да бъдат включени в резултатите от търсенето на изображения. Обектът още не е готов за демонстрация, която да бъде индексирана от робота.Трябва да се има предвид, че информацията, която потребителят иска да получи от търсачката, е достъпна за всеки, който въвежда URL адреса. Не трябва да използвате този текстов файл за скриване на поверителни данни. Ако домейнът има грешка от 404 (не е намерена) или 410 (минало), търсачката проверява сайта, въпреки наличието на robots.txt в този случай, смята, че файлът липсва. Други грешки, като например 500 (вътрешна грешка на сървъра), 403 (забранено), време за изчакване или "недостъпни", вземат предвид инструкциите на robots.txt, но байпасът може да бъде забавен, докато файлът е наличен.

Създай файл за търсене

Много CMS приложения, като WordPress, вече притежават файла robots.txt. Преди да можете правилно да конфигурирате Robots txt WordPress, трябва да се запознаете с неговите възможности, за да разберете как да го използвате. Ако програмистът сам създаде файл, той трябва да отговаря на следните условия:

Трябва да е написан с малки букви. Използвайте UTF-8 кодиране. За да запишете файл (.txt) в текстов редактор.Когато потребителят не знае къде да го постави, той ще се свърже със своя доставчик на софтуерОсигуряване на уеб сървър, за да научите как да получите достъп до корена на домейна или да отидете в Google конзолата и да го изтеглите. С тази функция Google може да провери дали ботът работи правилно и списъкът на сайтовете, които са били блокирани с помощта на файла.

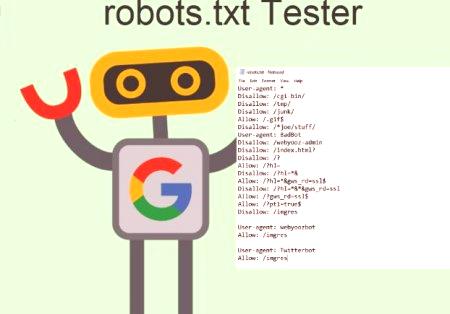

Основният формат на правилните текстове на Robots за битрикса:

Легендата robots.txt. #, коментари, които се използват само като бележки. Тези коментари ще бъдат игнорирани от скенерите заедно с всички потребителски грешки. User-agent - Показва коя търсачка са указани инструкциите за файла. Добавянето на звездичка (*) указва на скенерите, че инструкциите са създадени за всички.Посочете конкретен бот, като Googlebot, Baiduspider, Applebot. Disallow, казва на скенерите кои части от сайта не трябва да сканират. Изглежда така: User-agent: *. Звездата означава "всички ботове". Можете обаче да посочите страници за конкретни роботи. За да направите това, трябва да знаете името на бота, за който са зададени препоръки. Правилните текстове за роботите на Yandex могат да изглеждат така:

Ако ботът не трябва да заобикаля сайта, можете да го посочите, а за да намерите имената на потребителските агенти, се препоръчва да се запознаете с възможностите на useragentstring.com онлайн.

Оптимизиране на страниците

Две такива линии се считат за пълния файл robots.txt, с един роботен файл, съдържащ няколко реда потребителски агенти и директиви, които забраняват или позволяват обхождане. Основният формат на правилните текстове на роботите:

Потребителският агент: [потребителско име на агент]. Disallow: [URL низ, който не е сканиран].Във файла всеки блок от директиви се показва като дискретна, разделена линия. Във файла, заедно с потребителската директория на агента, всяко правило се използва по отношение на определен набор от разделени низове. Ако даден файл има правило, което се прилага за множество агенти, роботът ще разгледа само най-специфичната група инструкции.

Технически синтаксис

Може да се разглежда като "език" на файловете robots.txt. Съществуват пет термина, които могат да съществуват в този формат, като основните включват:

User-agent е уеб робот с инструкция за обхождане, обикновено търсачка. Disallow - Команда, използвана за насочване на потребителя към агента за необходимостта (преминаването) на конкретен URL адрес. За всяко от тях има само едно забранено условие. Позволете. За Googlebot, който има достъп, дори и персонализираната страница е забранена. Crawl-delay (Закъснение при обхождане) - Определя колко секунди ще трябва да се премине през скенера. Когато ботът не го потвърди, скоростта се задава в конзолата на Google. Sitemap - Използва се за определяне на местоположението на всички свързани с XML карти, свързани с URL адреса. Сравнение на модели

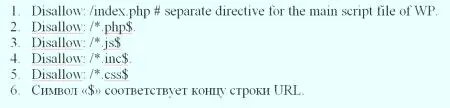

Когато става въпрос за действителните URL адреси за блокиране или разрешаване на правилните текстове на роботи, операциите могат да бъдат доста сложни, тъй като ви позволяват да използвате съвпадение на шаблони, за да достигнете до няколко възможни URL параметри. Google и Bing използват два знака, които идентифицират страниците или подпапките, които SEO иска да изключи. Тези два знака имат звездичка (*) и знак за долар ($), където: * е знакзаместване, представляващи всяка последователност от символи. $ - съответства на края на URL адреса.

Google предлага голям списък от възможни синтаксиси за шаблонни задачи, които обясняват на потребителя как да конфигурира файла Robots txt. Някои често използвани приложения включват:

Предотвратяване на появата на повтарящо се съдържание в резултатите от търсенето. Запазване на всички раздели на уебсайта насаме. Запазване на вътрешни страници с резултати от търсенето въз основа на отворено изявление. Посочване на местоположението.

Предотвратяване на търсачките за индексиране на определени файлове. Показва байпас за забавяне, за да спре претоварването, като едновременно сканира няколко области от съдържанието. Проверка на наличието на робот файл

Ако няма зони за сканиране, тогава robots.txt изобщо няма да се изисква. Ако потребителят не е сигурен какъв е този файл, той трябва да бъде въведен в основния домейн и да въведе в края на URL адреса, приблизително: moz.com/robots.txt. Редица търсачки игнорират тези файлове. Въпреки това, като правило, тези скенери не принадлежат към авторитетни търсачки. Те идват от различни спамери, пощенски агрегати и други видове автоматизирани ботове, които са широко достъпни в интернет. Важно е да запомните, че използването на стандарт за изключване на роботи не е ефективна мярка за сигурност. Всъщност някои ботове могат да започнат със страниците, на които потребителят задава режима на сканиране. Има няколко части, които са включени в стандартния файл за изключване. Преди да разкажете за работастраници, които не трябва да работят, трябва да посочите кой робот да говори. В повечето случаи потребителят ще използва проста декларация, която означава "всички ботове".

Оптимизация SEO

Преди оптимизиране, потребителят трябва да се увери, че не блокира никакво съдържание или части от сайта, които трябва да бъдат прескочени. Връзките към страниците, блокирани от правилните текстове на Robots, няма да бъдат спазвани. Това означава:

Ако те не са свързани с други страници, които са достъпни за търсачките, т.е. страниците не са блокирани от robots.txt или мета-робот, и свързаните с тях ресурси няма да бъдат сканирани и следователно не могат да бъдат индексирани. Не може да се предава връзка от заключена страница към връзка за местоназначение. Ако има такава страница, най-добре е да използвате различен механизъм за заключване, отколкото robots.txt.Тъй като други страници могат директно да се свържат към страница, която съдържа лична информация и искате да блокирате тази страница от резултатите от търсенето, използвайте различен метод, като например защита с парола или данни за метаданни noindex. Някои търсачки имат няколко персонализирани агенти. Например Google използва Googlebot за стандартно търсене и Googlebot-Image за търсене на изображения. Повечето персонализирани агенти от една и съща търсачка следват едни и същи правила, така че не е необходимо да се указват директиви за всеки един от няколкото търсещи роботи, но с възможността да направят това може точно да конфигурира проверката на съдържанието на сайта. Търсачката кеширасъдържанието на файла и обикновено актуализира съдържанието на кеширане поне веднъж на ден. Ако потребителят промени файла и иска да го актуализира по-бързо от стандартното, той може да изпрати URL адреса на robots.txt на Google.

Търсачки

За да разберете как работи текстовете с роботи, трябва да знаете за възможностите на търсачката. Накратко, техните възможности се крият във факта, че те изпращат "скенери", които са програми, които разглеждат Интернет за информация. След това те съхраняват част от тази информация, за да я предадат на потребителя. За много хора Google е интернет. Всъщност, те са прави, защото това е може би най-важното му изобретение. И въпреки че търсачките са се променили значително от създаването си, техните основни принципи са едни и същи. Скенерите, известни също като "ботове" или "паяци", намират страницата от милиарди уебсайтове. Търсачките им дават указания къде да отидат, докато отделните сайтове също могат да взаимодействат с ботове и да им кажат кои конкретни страници трябва да гледат. Като правило, собствениците на сайтове не искат да се показват в търсачките: административни страници, бекендали, категории и маркери, както и други информационни страници. Можете също да използвате файла robots.txt, така че търсачките да не сканират страници. Накратко, robots.txt казва на уеб роботите какво да правят.

Забранени страници

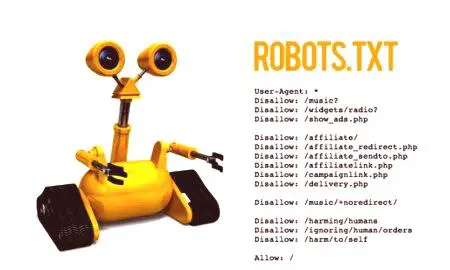

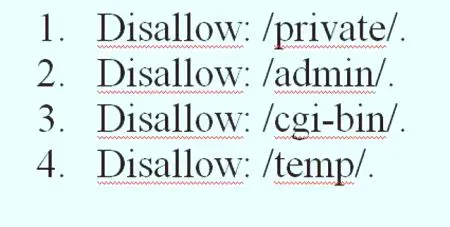

Това е по-голямата част от файла за изключване на роботи. С обикновена реклама потребителят определя бота или групата ботове, така че да не обхождат определенистраница. Синтаксисът е прост, например, за забрана на достъпа до всичко в директорията "admin" на сайта е написано: Disallow: /admin. Този ред ще попречи на роботите да обхождат yoursite.com/admin, yoursite.com/admin/login, yoursite.com/admin/files/secret.html и всичко останало, което попада под администраторската директория. За да забраните една страница, просто я насочете към лентата: Disallow: /public/exception.html. Сега страницата "изключение" няма да бъде преместена, а всичко останало в "публичната" папка. За да включите няколко страници, просто ги посочете:

Тези четири реда от правилните текстове на Robots за симфония ще се прилагат за всеки потребител на агента, посочен в горната част на секцията # robots.txt за https://www.symphonyspace.org/.

Карта на сайта: https://www.symphonyspace.org/sitemaps/1/sitemap.xml. Други команди: # live - не позволяват на роботите да индексират cpresources /или доставчика /. Потребителски агент: * Disallow: /cpresources /. Disallow: /Производител /Disallow: /.env.

Определяне на стандарти

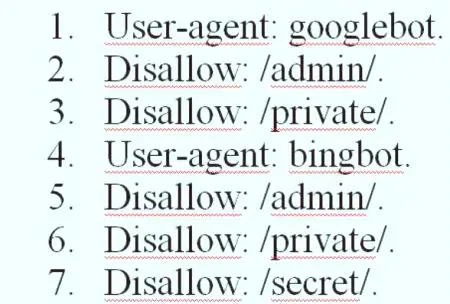

Потребителят може да определи конкретни страници за различни ботове, комбинирайки предишните два елемента, така изглежда. По-долу е представен пример за правилните текстове на Robots за всички търсачки.

Секциите "admin" и "private" са невидими за Google и Bing, но Google все още ще вижда "секретната" директория, докато Bing няма да направи това. Можете да посочите общи правила за всички ботове, като използвате потребителския агент със звездичка, и след това дайте конкретни инструкции на ботовете в следващите раздели. С познанията по-горе, потребителят може да напише пример за правилните текстове Robots за всички търсачки. Просто стартирайте любимия си текстов редактор иИнформирайте ботове, че не са добре дошли в определени части на сайта.

Съвети за повишаване на производителността на сървъра

SublimeText е универсален текстов редактор и златен стандарт за много програмисти. Освен това софтуерните му съвети се основават на ефективно кодиране. потребителите оценяват наличието на преки пътища в програмата. Ако потребителят иска да види пример на файл robots.txt, отидете на някой сайт и добавете "/robots.txt" към края. Тук е част от файла GiantBicycles robots.txt. Програмата осигурява създаването на страници, които потребителите не искат да показват в търсачките. Също така има някои изключителни неща, за които малко хора знаят. Например, ако файл robots.txt казва на ботове, където не е нужно да отидете, Sitemap прави обратното и им помага да намерят това, което търсят, и въпреки че търсачките вероятно вече знаят къде е картата на сайта, тя не им пречи. Има два типа файлове: HTML страница или XML файл. HTML страница е тази, която показва на посетителите всички съществуващи страници в сайта. В собствения си файл robots.txt изглежда така: Sitemap: //www.makeuseof.com/sitemap_index.xml. Ако даден сайт не е индексиран от търсачките, въпреки че е обхождан няколко пъти от уеб роботите, трябва да се уверите, че файлът е и дали неговото разрешение е зададено правилно. По подразбиране това ще се случи с всички инсталации на SeoToaster, но ако е необходимо, можете да го възстановите, както следва: Файл robots.txt - 644. В зависимост от PHP сървъра, ако той не работи за потребителя, се препоръчва да опитате следното: Файл robots.txt - 666

Задаване на закъснението за сканиране

Директива за закъснение на Dodgeказва на определени търсачки колко често могат да индексират страницата в сайта. Той се измерва в секунди, въпреки че някои търсачки го интерпретират по различен начин. Някои виждат забавяне от 5 байпас, когато им кажат да изчакат пет секунди след всяко сканиране, за да започнат следващия. Други интерпретират това като инструкция за сканиране само на една страница на всеки пет секунди. Роботът не може да сканира по-бързо, за да спести трафик на сървъра. Ако сървърът трябва да съответства на трафика, той може да зададе закъснение при пътуване. Като цяло, в повечето случаи потребителите не трябва да се притесняват за това. Ето как настройката за закъснение при обхождане от 8 секунди е зададена на Crawl-delay: 8. Но не всички търсачки ще се подчиняват на тази директива, така че когато забраните страници, можете да зададете различни закъснения при обхождане за определени търсачки. След като всички инструкции във файла са конфигурирани, можете да го изтеглите на сайта, първо се уверете, че той е прост текстов файл и има името robots.txt и може да бъде намерен на yoursite.com/robots.txt.

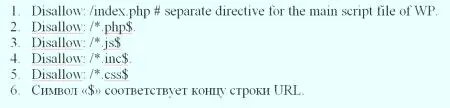

Най-добър бот за WordPress

WordPress има някои файлове и директории, които трябва да бъдат блокирани всеки път. Каталозите, които потребителите трябва да забранят - това е каталогът на cgi-bin стандартните WP директории. Някои сървъри не позволяват достъп до директорията cgi-bin, но потребителите трябва да го включат в директивата disallow преди да конфигурират правилно текстовите текстове на WordPress, а стандартните WordPress директории трябва да бъдат блокирани. Тези директории нямат никакви данни, които първоначално са полезни за търсачкитесистеми, но има изключение, т.е. в директорията wp-content има поддиректория с име uploads. Тази поддиректория трябва да бъде разрешена в файла robot.txt, тъй като включва всичко, което се зарежда с помощта на функцията за качване на носители на WP. WordPress използва етикети или категории, за да структурира съдържанието. Ако се използват категории, за да се направят правилните Robots txt за Wordpress, както е посочено от производителя на програмата, трябва да заключите архивите на маркерите за търсене. Първо проверете базата данни, като отидете на панела Администриране & gt; Настройки & gt; "Permalink". По подразбиране базата е етикет, ако полето е празно: Disallow: /tag /. Ако използвате категория, трябва да блокирате категорията в файла robot.txt: Disallow: /category /. По подразбиране базата е етикет, ако полето е празно: Disallow: /tag /. Ако използвате категория, трябва да блокирате категорията в файла robot.txt: Disallow: /category /. Файловете, които се използват предимно за показване на съдържанието, са блокирани от правилния файл Robots txt за Wordpress:

Главна инсталация на Joomla

След като потребителят е инсталирал Joomla, трябва да видите правилната конфигурация на Robots txt Joomla глобалната конфигурация, която се намира в контролния панел. Някои от настройките тук са много важни за SEO. Първо, намерете името на сайта и се уверете, че се използва краткото име на сайта. След това намират набор от настройки вдясно на екрана, наречени SEO настройки. Този, който определено трябва да промените, е вторият: използвайте URL адреса на презаписването. Звучи трудно, но основноПомага на Joomla да създава по-чисти URL адреси. Най-вече, ако премахнете реда index.php от URL адресите. Ако я промените по-късно, URL адресите ще се променят и Google няма да се хареса. Въпреки това, когато промените тази опция, трябва да направите няколко стъпки, за да създадете правилния текстов робот за Joomla:

В главната директория на Joomla намерете файла htaccess.txt. Маркирайте го като .htaccess (без разширение). Включете заглавието на сайта в заглавията на страниците. Намерете настройките за метаданни в долната част на екрана за глобална конфигурация. Робот в облака MODX

По-рано MODX Cloud предостави на потребителите възможност да контролират поведението на файла robots.txt за поддръжка въз основа на превключването в мониторинговия панел. Въпреки че е полезно, можете случайно да позволите индексиране на сайтовете за заснемане /dev, като превключите опцията на Dashboard. По същия начин индексирането на мястото на производство може лесно да бъде забранено. Днес услугата разглежда наличието на файлове robots.txt във файловата система със следните изключения: всеки домейн, който завършва, modxcloud.com ще служи като директива Disallow: /за всички потребителски агенти, независимо от наличието или отсъствието на файла. За производствени сайтове, които получават реални посетители в трафика, ще трябва да използвате собствен домейн, ако потребителят иска да индексира сайта им. Някои организации използват правилните текстове на Robots, за да може modx да изпълнява множество уеб сайтове от една инсталация, използвайки Contexts. Случаят, в който това може да се приложи, ще бъде публичен маркетингсайт във връзка с микро-сайтовете на целевата страница и евентуално непубличен интранет. Традиционно беше трудно да се направи за многопотребителски инсталации, тъй като те споделят един и същ корен на мрежата. MODX Cloud може да направи това лесно. Просто качете допълнителен файл на уебсайта, наречен robots-intranet.example.com.txt с такова съдържание и той ще блокира индексирането, използвайки добре функциониращи роботи, а всички останали имена на хостове ще се върнат към стандартните файлове, ако няма други конкретни имена. Robots.txt е важен файл, който помага на потребителя да се свърже с сайт в Google, главните търсачки и други уебсайтове. Разположен в основата на уеб сървъра - файлът инструктира уеб роботите да обхождат сайта, който задава всички папки, които той трябва или не трябва да индексира, като използва набор от инструкции наречени протокол за премахване на роботи. Пример за правилния робот txt за всички търсачки obots.txt е особено прост с SeoToaster. Той има специално меню в контролния панел, така че ботът никога няма да се натоварва, за да получи достъп.